Facebook, die Wirklichkeitsmaschine

Politisches war schon immer ein gefährliches Small-Talk-Thema. Das Risiko, dass aus einer angenehmen Unterhaltung ein erbitterter Streit wird, war aber selten so gross wie jetzt, sei es aus Pandemie-Genervtheit, allgemeinem Unsicherheitsgefühl oder aus tieferliegenden Gründen. Am sichtbarsten ist diese Spaltung derzeit in den USA.

Anhänger der beiden grossen US-Parteien stehen sich gegenüber, als ob sie in unterschiedlichen Welten leben würden. Das tun sie tatsächlich – in den sozialen Medien zumindest, allen voran auf Facebook, dem Pionier der kuratierten Wirklichkeit. Einigen können sie sich anscheinend nur noch auf herzige Tierbilder – kein gutes Zeichen für die Demokratie.

Bloss nicht über Politik reden

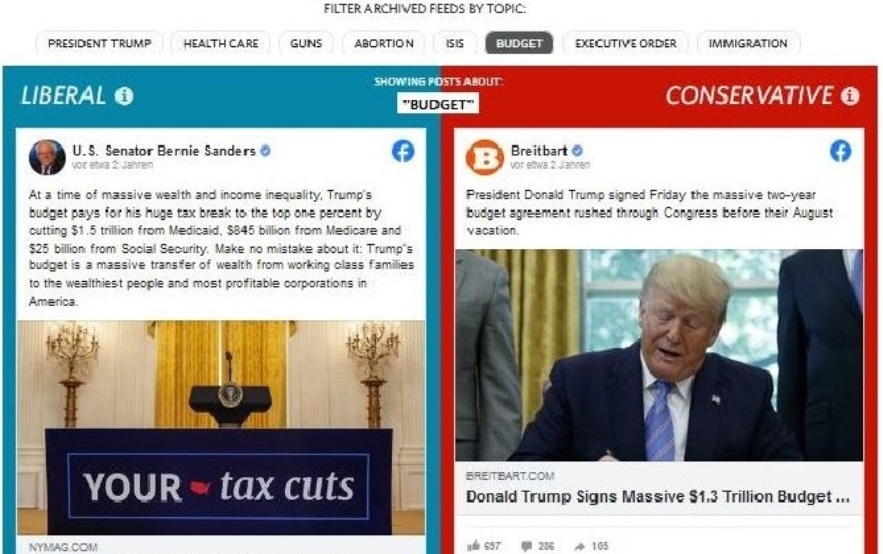

Wie unterschiedlich Facebook-Nutzende die Welt präsentiert bekommen, zeigte schon vor einigen Jahren ein Projekt des «Wall Street Journal» (WSJ). «Blue Feed, Red Feed» stellt gegenüber, wie Nutzer, die den Demokraten oder den Republikanern zuneigen, ihren Facebook-Feed sehen.

Leser können sich auf der Seite demokratisch blaue oder republikanisch rote Timelines zu den Themen Trump, Gesundheit, Waffen, Abtreibung, ISIS, Haushalt, Executive Order und Immigration ansehen, die allerdings schon etwas älter sind. Das Projekt wird seit August 2019 nicht mehr aktualisiert.

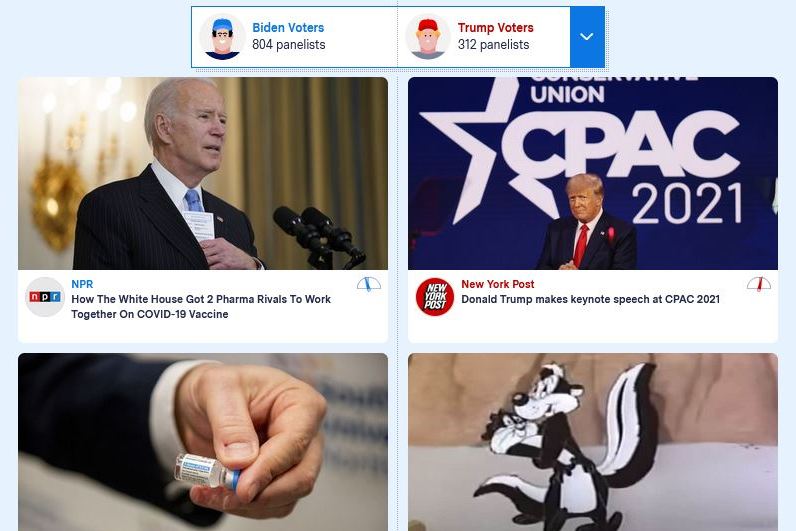

Das US-Tech-Magazin «The Markup» hat die Idee weiterentwickelt und eine Browsererweiterung programmiert, die aufnimmt, was jemand in seinem Feed sieht. Freiwillige spenden im Rahmen eines Citizen-Science-Projekts ihre Daten zur Auswertung.

«Ich wusste nicht viel über einige Dinge, die im Trump-Feed zu sehen sind. Ich habe buchstäblich nie davon gehört.» Eli Pariser, Politologe

Auf der interaktiven Seite «Split Screen» kann man die Ergebnisse vergleichen. Die Seite zeigt, was Demokraten und Republikaner, Männer und Frauen sowie Ältere und Jüngere (Millenials und Boomer) in ihren Facebook-Feeds sehen, welche Hashtags sie verwenden und welche Facebook-Gruppen ihnen empfohlen werden. Die Software vergleicht dabei Posts, die in beiden Feeds abweichen. Katzenbilder gibt es also nicht, auch keine persönlichen Postings.

Selbst der Politologe und Aktivist Eli Pariser, der «Split Screen» ausprobiert hat, war erstaunt. Pariser, der vor zehn Jahren den Begriff «Filter Bubble» erfunden hat, fand erwartungsgemässs «Dinge, die ich als Liberaler niemals so sehen würde». Von einigen Inhalten im Trump-Feed habe er aber wirklich noch nie gehört, sagte er im Interview mit «The Markup».

Am Anfang war der personalisierte Feed

Begonnen hat die gespaltene Online-Realität mit der breiten Anwendung von künstlicher Intelligenz (AI) und dem Einsatz selbstlernender Programme. Die Journalistin Karen Hao gibt in einem Artikel für die «MIT Tech Review» einen Einblick, wie Facebook zum Vorreiter und der AI-kuratierte Nutzerfeed die Regel wurde. Sie verfolgt den Weg des AI-Spezialisten Joaquin Quiñonero Candela, dem Leiter der Abteilung «Angewandte künstliche Intelligenz», mit dem sie mehrere Interviews geführt hat.

Die neue Technologie zahlte sich für Facebook in Form von Wachstum und Werbeeinnahmen schnell aus. Ein Gewinn, der dem Unternehmen auf die Füsse fiel. Da war beispielsweise der Skandal um das Unternehmen «Cambridge Analytica», das massenweise Nutzerdaten aus Facebook absaugte, die Rolle Facebooks beim Genozid an den Rohingya in Myanmar oder der Vorwurf, Facebook würde konservative Inhalte in den USA unterdrücken.

Zuletzt gipfelte der Empörungsbeschleuniger in der Erzählung der «gestohlenen Präsidentenwahl», die vor allem auf Social Media verbreitet wurde. Eine der Folgen: der Sturm auf das US-Kapitol im Januar 2021.

Menschliches in hoher Beschleunigung

Quelle der Eskalation ist eine alte Weisheit: Besonders intensiv reagieren Menschen auf Dinge, die sie interessieren, berühren und vor allem auf alles, was sie aufregt. Bekommen sie viele solche Inhalte in schneller Folge vorgelegt, ist die Eskalation absehbar. Was übrig bleibt, ist eine Mischung aus Fake News, Hass, Gewalt und Katzenbildern.

Vermutlich trifft das auch auf andere soziale Netzwerke zu, die ihre Inhalte nach Nutzervorlieben kuratieren, nicht nur auf Facebook. Untersuchungen anderer sozialer Medien gibt es noch nicht.

Ganz so einfach ist es trotzdem nicht. Moderiert wurde schon immer, ob persönlich oder maschinell. Tatsächlich gibt es bei Facebook etliche Programme, die die Nutzererfahrung steuern, Inhalte sortieren, unterdrücken, priorisieren, empfehlen. Sie stehen teilweise in Konkurrenz zueinander und müssen aufeinander abgestimmt werden.

Neues Problem, neues Programm

Selbstlernende Algorithmen können sich im Gegensatz zu solchen, die von Programmierern festgelegt werden, über die Zeit verändern und müssen überwacht werden. Neue Probleme tauchen auf. So kann ein Algorithmus, der gelernt hat, Holocaust-Leugnung zu erkennen, Genozid in Myanmar kaum erfassen. Taucht zum Beispiel eine neue Verschwörungserzählung in Indien auf, muss neue Software mit einer grossen Anzahl Posts darauf trainiert werden, sie zu finden.

Dass Facebook von den Auswirkungen der AI-gesteuerten Empörungsspirale nichts wusste, ist widerlegt. Das Problem der Entwickler: Facebook soll keine Schlangengrube werden, aber die Polarisierung zahlt sich aus. Oberstes Ziel ist, dass Nutzerinnen und Nutzer möglichst lange auf Facebook verweilen. Je länger sie dort sind, desto mehr Werbung schauen sie sich an – die Geschäftsgrundlage von Facebook.

Hao zeigt auf, welche Teams und Ideen für Facebook über die Jahre strukturell und finanziell Vorrang hatten. Facebook testet ein neues Programm meist zunächst an einer kleinen Anzahl Nutzer. Schränke es die Kundenbindung zu sehr ein, werde es nicht weiter priorisiert, berichtet sie.

Was Facebook als «fair» betrachtet

Facebook hat mehrmals versichert, es strebe danach, «verantwortungsvoll und fair» zu handeln. Was man ruhig hinterfragen darf. «Ich verstehe nicht einmal, was sie [die Leute von Facebook] meinen, wenn sie von Fairness sprechen», sagt die Journalistin Ellery Roberts Biddle, die sich mit den digitalen Rechten der Zivilgesellschaft beschäftigt. «Wenn jeder die Empfehlung [für die gleiche extremistische Gruppe] bekommt, heisst das dann, dass es fair ist?»

Genau das ist mit einem Programm namens «Fairness Flow» geschehen, das «AI Bias», also die Diskriminierung bestimmter Nutzergruppen durch lernende Programme, verhindern soll. Fairness, dokumentierte das Programmiererteam, bedeute, dass eine Gruppe, die mehr Desinformation verbreite, auch stärker zensiert werde. Posten konservative Nutzer mehr Fake News als liberale, greift der Algorithmus demnach stärker ein. Eingesetzt wurde «Fairness Flow» aber anders: Die Nutzergruppen wurden gleich priorisiert.

Welchen Einfluss das auf die Demokratie hat

Für die Demokratie sind Spaltung und Eskalationsturbo in den sozialen Netzwerken noch kein Beinbruch, aber eine Herausforderung, sagt Pariser. Wenn sich zwei Personen unterschiedlichen Alters, Geschlechts oder unterschiedlicher politischer Präferenzen über ein Thema unterhalten, sprachen sie noch nie über exakt dieselbe Sache, erklärt er.

Wer welche Information konsumiere, sei schon immer unterschiedlich gewesen. Ob jemand «Fox News» anschaut oder die «New York Times», kann er selbst wählen. Auch die Offline-Welt sah noch nie für alle gleich aus. Aber die Schnittmengen sind kleiner und die Gruppen grösser geworden.

Parisers Theorie von den «Filter Bubbles» oder Echokammern hat sich teilweise überlebt. Aber je mehr sich Leute in personalisierten Feeds informierten, desto mehr verschwinde der gemeinsame Bezugspunkt. Wie weit der eigene Standpunkt abweicht, könne der Einzelne nicht mehr abgleichen, es sei denn, er gebe sich Mühe. «Es ist so schlimm gekommen, wie ich befürchtet habe», sagt er heute.

Statt sich die eigenen Vorurteile ständig bestätigen zu lassen, etwa indem er seine schlechte Meinung über «Fox News» und die Menschen verstärke, die dieses Medium konsumieren, könne er sich mit jemandem auf einen Kaffee treffen, der «Fox» schaut. Das helfe, zu verstehen, wie dieser ticke.

Themenbezogene Interessenbindung der Autorin/des Autors

Keine.

Facebook ist wohl, so möchte ich behaupten, eine Spielwiese für PR Unternehmen, die Meinungen lenken und bilden können; unabhängig davon, ob Behauptungen die dort abgegeben werden, überhaupt annähernd wahr sind.

Mit den «neuen Medien» kann man ungalublich viel Einfluss nehmen, weshalb ich für meinen Teil schon ganz froh bin, das sich nicht alle Medien das selbe Lied spielen.

Von Infosperber habe ich z.B. aus einem Buch mit dem Titel «Mega Manipulation erfahren.

https://www.westendverlag.de/buch/mega-manipulation/

Dann noch das Buch «Weltbeherrscher» dazu und die Infos schlagen dem Fass den Boden aus.

Das soll jetzt keine Werbung für die Bücher sein, doch aber ein Hinweis auf zwei interessante Quellen, die so manchem die Gesichtszüge entgleisen lassen werden. Das ganze ist sehr viel umfangreicher und verwobener, als wir es wohl annehmen. Nichts ist zufällig, da bin ich mir mittlerweile sicher.

Was mich doch sehr irritiert ist auch, das in der Schweiz auch nicht alles so toll ist wie so mancher hier in Deutschland glaubt. Besser vielleicht als bei uns, aber eben nicht so wie in der Vorstellung.

Schön das es diese Seite gibt! Danke an alle Beteiligten dafür.

Wenn die helvetischen Medien-Mogule wie Tagesanzeiger-Verlag, SRF usw. und endlich auch infosperber solche Methoden anwenden, haben wir endlich die «Neue schöne Zeit» 😀